FAIR

Auf einen Blick

|

Forschungsprojekt |

FAIR — Fast Artificial Intelligence Rendering |

|---|---|

|

Fachbereich |

Ingenieurwissenschaften |

|

Institut |

Medientechnik |

|

Leitung |

Prof. Dipl.-Ing. Mike Christmann |

|

Beteiligte |

Prof. Dr. Rolf Hedtke |

|

M.Eng. Mark Benyamin |

|

|

M.Eng. Pascal Kutschbach |

|

|

B.Eng. Benjamin Donderer |

|

|

Ansprechpartner Forschungsförderung |

Dr. Michael Anton |

|

Projektpartner |

LYNX Technik AG |

|

Fördermittelgeber |

Land Hessen (Hessisches Ministerium für Wirtschaft, Energie, Verkehr und Landesentwicklung), LOEWE-3 Forschungsprojekt |

|

Laufzeit |

01.03.2024 - 31.12.2025 |

Projektbeschreibung

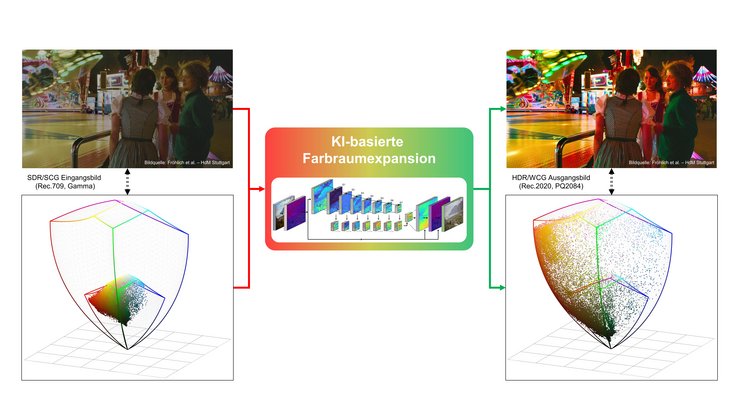

Mit der Einführung von neuen Bildformaten, wie UHDTV, soll eine dem menschlichen Sehvermögen angepasste Bildqualität erreicht werden. Dabei ist neben einer höheren örtlichen Auflösung (z.B. „4K“) vor allem ein höherer Dynamikbereich (HDR - High Dynamic Range) und ein größerer Farbumfang (WCG - Wide Color Gamut) spezifiziert. Um vorhandene Bildformate, z.B. semiprofessionelle oder ältere Kameras und Archivmaterial, in Zukunft an die Bildqualität des HDR/WCG-Formats (UHDTV) angleichen zu können, ist ein Konverter erforderlich, der die Bilder in Echtzeit wandelt. Dabei müssen Verfahren der künstlichen Intelligenz (KI) eingesetzt werden.

Die Medienschaffenden können damit bereits vorhandene Kameras auch bei neuen UHDTV-Produktionen einsetzen und die im Archiv befindlichen Aufnahmen automatisch in das HDR/WCG-Format wandeln. Darüber hinaus kann dieses Verfahren auch in anderen Bereichen vorteilhaft sein; so z.B. im medizinischen Bereich, im Bereich Automotive und im Überwachungsbereich.

Dafür soll ein Verfahren für Bewegtbildmaterial entwickelt werden, welches es erlaubt aus dem heute üblichen SDR/SCG-Fernsehbild ein kontrast- und farbenreiches HDR/WCG-Bild mit Details in Lichtern und Schatten zu schaffen. Um diese Informationen wieder so zu rekonstruieren, dass keine sichtbaren Unterschiede zu einem nativen HDR/WCG-Bild zu sehen sind, müssen Verfahren der KI eingesetzt werden. Die Entwicklung und die Implementierung der neuronalen Netze in Software, sowie die Erstellung der Trainingssequenzen und auch das Training selbst werden an der Hochschule RheinMain (HS-RM) auf Rechnern mit GPU-Unterstützung durchgeführt. Die Umsetzung in die Hardware übernimmt die Fa. LYNX. Dabei soll eine programmierbare Einheit mit großem FPGA verwendet werden, auf der die Bildverarbeitungsverfahren als Applikationen geladen und in Echtzeit ausgeführt werden können. Dazu muss die an der HS-RM entwickelte KI-Software in eine Hardware-nahe FPGA-Programmierung überführt werden. Wesentliche Alleinstellungsmerkmale dieses Projektes sind vor allem die hohe Bildqualität durch die Wandlung nach HDR/WCG mit einem Bildverarbeitungsgerät für das professionelle Medienumfeld sowie die Anwendung von KI in einem FPGA in Echtzeit.

Der Nutzen für den Kunden besteht darin, dass die bereits vorhandenen HDTV-Kameras auch in UHDTV-Produktionen eingesetzt werden können. Damit kann die vorhandene Infrastruktur weiterverwendet werden und auch die im Archiv befindlichen Aufnahmen im HDTV-Format durch diese Konvertierung automatisch in das neue HDR/WCG-UHDTV-Format gewandelt werden. Dabei sollte der Zuschauer keinen Unterschied zwischen der Originalaufnahme in HDR/WCG und dem hochkonvertierten Material bemerken. Da hierbei wesentliche Einsparungen bei den Kunden möglich sind und es noch keine vergleichbaren Geräte mit dieser Leistungsfähigkeit gibt, ist mit einer schnellen Verbreitung auf dem Markt zu rechnen.

Die Anwendung der KI zur hochqualitativen Videoverarbeitung stellt den nächsten Innovationssprung in der Medientechnik dar. Daher bietet dieses Projekt für die Hochschule RheinMain die Möglichkeit zur praxisnahen Forschung auf diesen Gebieten.